今天分享一个教程吧,讲一讲使用 Cursor 如何零基础的来开发一个爬虫的浏览器插件?

为什么讲爬虫呢?春节前,咱们星球的一个球友咨询过我一个问题,他想使用 Cursor 做一个爬虫的项目,然后没有成功,使用的是 C# ,配置 .net 的开发环境,最后,开发环境太复杂了,对于非技术人员来讲,太难了。

其实,对于普通的小白来讲,如果想使用 AI 编程工具 Cursor 开发一个工具类的软件,且不需要配置开发环境的前提下,最简单的方式其实就是采用浏览器插件的方式。

因为浏览器就是环境啊,这不需要你配置,当然了,这种情况下,开发太复杂的功能可能就不行了,简单的工具就用浏览器插件的方式就行。

所以,这次咱们依旧是采用浏览器插件的形式来开发一个爬虫的小项目。

第一步:确定爬虫网页的标签元素

第一步,我们肯定要确定你要爬虫的网页的标签元素。

这里的标签元素就是 html 的标签。html 是超文本标记语言,开发网页的基础技术,我们看到的网页排版布局,展示的效果都是采用了 html 这种形式。

我举个例子,我想爬虫 36 氪新闻网页中的新闻标题和摘要。那我要首先找到目标网页地址,然后点击鼠标右键,选择点击「检查」,来查看网页的标签元素。

这里我的目标网页,网页地址:https://36kr.com/information/web_recommend/

我们打开浏览器的控制台,找到页面元素,把我们要爬虫的新闻的标题和摘要的 HTML 标签元素复制出来。

标题的:

<a class=”article-item-title weight-bold” href=”/p/3147329369578241″ target=”_blank” rel=”noopener noreferrer” sensors_operation_list=”page_flow”> 瑞幸涨价,“背刺” 返乡打工人 </a>

摘要的:

<a class=”article-item-description ellipsis-2″ href=”/p/3147329369578241″ target=”_blank” rel=”noopener noreferrer”> 咖啡行业的价格战,会就此结束吗?</a>

我们留着有用,一会给 Cursor 指令的时候,需要发给它,它就知道该如何去解析网页,帮你爬虫对应的数据了。

到这里,我们就一定确定好了爬虫的目标网页标签元素了。

接下来,我们就可以给 Cursor 发指令了。

第二步:让 Cursor 帮我们自动化编程

首先,我们在电脑上新建一个空文件夹,作为项目目录,然后打开 Cursor AI 编程工具的时候,选择你新建的文件夹目录。

Cursor 打开之后,使用快捷键 command + i ,windows 电脑是 ctrl + i ,调出 composer 。

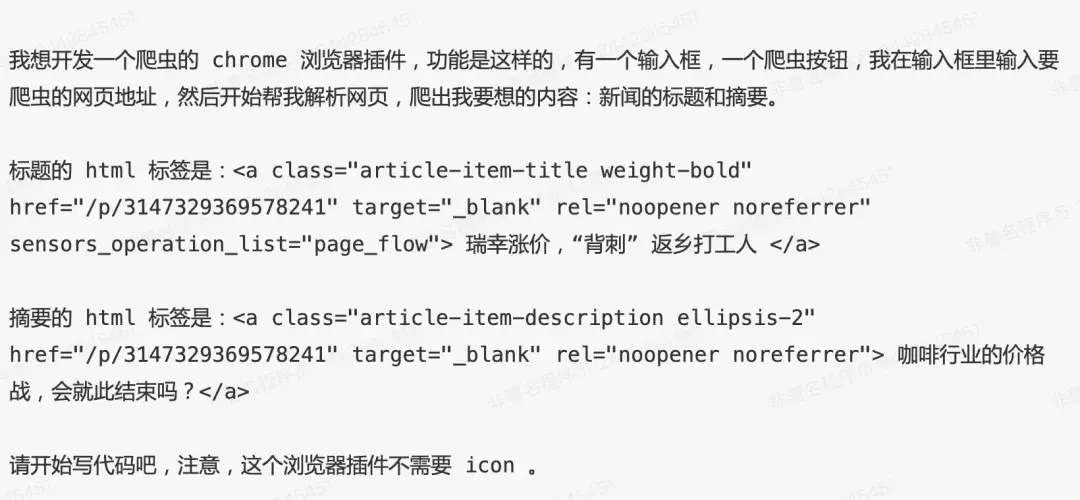

然后给它发送指令,提示词如下:

看到了吗?我们提示词用到了刚才定位到的网页标签元素。它就会根据网页标签元素来去解析网页,找到爬虫的目标内容。

到这里,Cursor 就开始自动编程了。

一次性成功,直接帮我开发完成了。

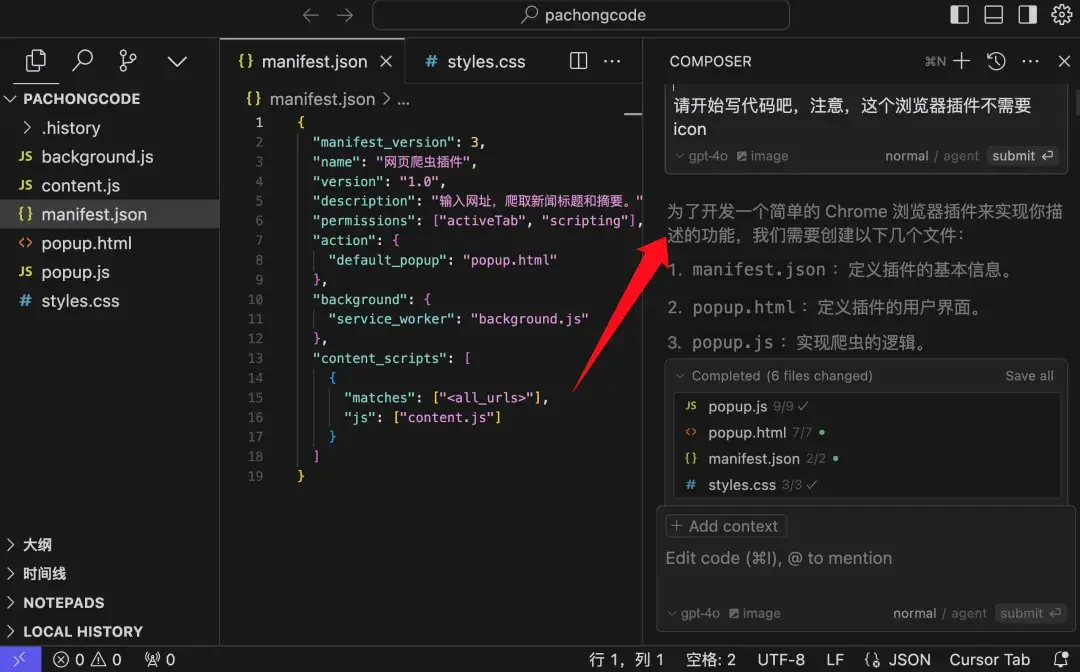

看看运行效果,如下:

看看怎么样?我把网址复制进去,点击爬虫,把这个网页下的新闻标题和摘要都爬出来了吧?

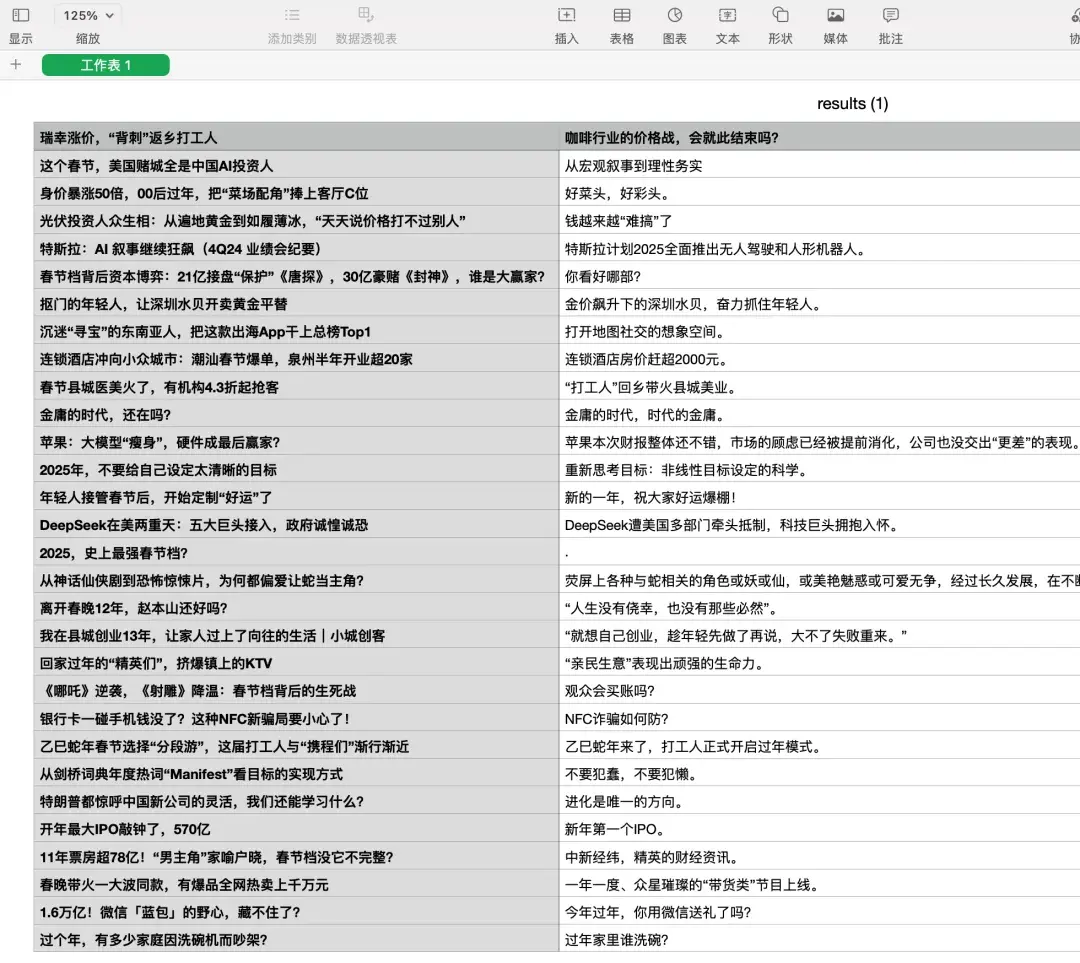

继续,完善代码,后来,我又新增了一个提示词,增加一个下载按钮,将爬虫的内容,下载下来,我一开始想下载 excel 表格来,但是,excel 表格可能需要引入外部的第三方库,太麻烦了,我就又改成了下载爬虫的内容变成 csv 文件,大家可以将 csv 文件转成 excel 表格,在 excel 表格输入导入中支持 csv 文件。

最终的效果就是:

看看效果完美不?下载的文件展示如下:

是不是把这个网页当中的新闻标题和摘要都爬出来了?

整个过程就是这样的,非常简单,其实,对于小白来讲最难的就是如何定位目标内容的 html 标签元素。